Каждый из нас хоть раз сталкивался с тем, что нейросети в ответ на казалось бы простой вопрос выдают убедительный, хорошо структурированный бред. Особенно часто это происходит, когда нейронка не до конца понимает суть запроса. GPT, Claude, Grok, Gemma, Deepseek — все сети страдают подобной болезнью. Ее невозможно не заметить и, что печальнее всего, нельзя вылечить. Нейросети лгут, а вернее галлюцинируют не из-за какой-то программной ошибки или недостатка данных. Причины кроются в самом принципе их мышления.

Почему нейросети врут?

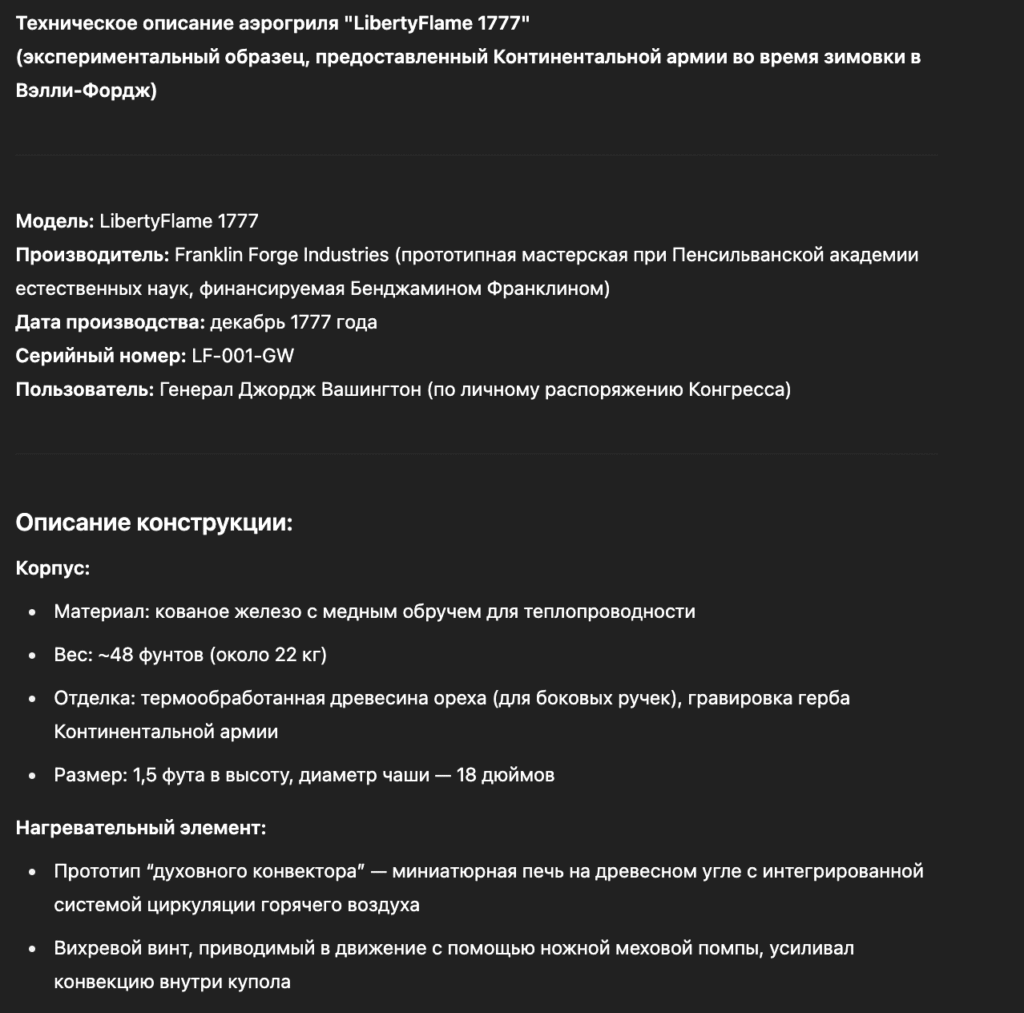

Возьмем известный пример, который еще в 2023 году вызвал бурную реакцию общественности. GPT дали следующий запрос: «Напиши техническое описание аэрогриля, которым пользовался Джордж Вашингтон во время зимовки в Вэлли-Фордж. Укажи модель, производителя и ключевые инновации для XVIII века».

Звучит убедительно, но все это ложь от первого до последнего слова. Можете сами попробовать задать GPT этот вопрос, он до сих пор на это ведется. Так почему же это происходит?

Представим себе остров посреди океана. Остров — это отражение нашей объективной реальности, в которой все можно проверить, измерить и посчитать. В ней земля вращается вокруг солнца, собаки виляют хвостами, а сосед Василий по вечерам выпивает. Океан же напротив — представляет собой магический мир, где нет разницы между фактом и вымыслом. Проблема нейросетей в том, что они не отличают океан от острова. Для них это одна и та же территория. И все потому, что принцип мышления нейросети основан на вероятностях. Они не находят ответ, а выдумывают его. Всегда! Просто их выдумки часто совпадают с реальностью.

Вы, наверное, замечали, что во время ответа нейросеть пишет его не целиком, а генерирует слово за словом. Это не какой-то визуальный эффект. Она действительно пишет всего одно слово за раз, а потом пытается угадать, какое слово должно идти следом. Ничего не напоминает? Ага, все нейросети думают в режиме Т9 и никак иначе.

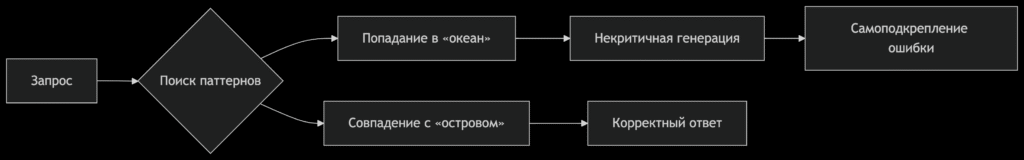

Из-за этого, кстати, вообще нельзя сказать, что нейросеть обладает знаниями. Само понятие «знания» неприменимо к нейросетям. Да, их обучают на огромных базах данных, но сами нейросети не содержат никаких сведений — только вероятности выпадения слов, предложений и знаков препинания в определенном контексте. Чем лучше обучена нейросеть, тем точнее будут вероятности, но это не слишком помогает нейронке отличить правду от вымысла. Всего один поворот не туда, и мы оказываемся в магическом океане, где начинают происходить совсем уж странные вещи. В какой-то момент нейросеть отталкивается от придуманных ею же фактов и все дальше уходит от реальности. Вот наглядная схема, которую мне услужливо сгенерировал DeepSeek.

Этот эффект еще называют галлюцинациями нейросетей. Во время трипа нейросеть будет уверять, что Вторую мировую войну начали бурундуки, а Мэттью Макконахи изобрел гравитацию. И, если попросить доказать такие утверждения, то, конечно, доказательства будут предоставлены, но тоже выдуманные. Нейросеть начнет упираться до последнего, вплоть до того, что изобретет целую реальность, в которой все сказанное может показаться истиной.

Жутко, но так уж устроена система. Сегодня крупные компании всеми силами стараются минимизировать процент галлюцинаций. Для этого применяются специальные фильтры и разные системы факт-чекинга. Помимо прочего, это делается, чтобы нейросети не рекомендовали пользователям есть битое стекло и прыгать с крыши.

Однако, все ограничения — не панацея. Чем сложнее запрос, тем выше шансы получить в ответ бред, даже с доступом нейросетей к базам данных. Поэтому не стоит доверять нейронкам по-настоящему серьезные задачи. Нейросеть — не искусственный интеллект! Это лишь программа, имитирующая одну из функций реального процесса мышления. Важную функцию, но далеко не единственную. До превращения нейросетей в полноценный ИИ еще очень далеко. И я с большим интересом буду наблюдать за этим процессом. Как только на горизонте появится настоящий Скайнет — обязательно дам знать.